多くの方がAI技術を使って業務の効率化を図る中で、特にChatGPTの安全な利用に関する関心が高まっています。

しかし、その利用にはセキュリティリスクが伴います。

本記事では、ChatGPTを利用する際のセキュリティ対策と安全な使用方法を詳しく解説します。

AIを安全に利用するための具体的な方法やポリシーについて学び、日々の業務に活かすことができます。

この記事は、企業でChatGPTを導入している情報セキュリティ担当者やIT管理者をターゲットとしています。

特に、AI技術を活用しながらセキュリティを確保する方法に興味を持つ方々にとって、有益な情報が含まれています。

株式会社QEDでは、ChatGPTを活用して業務を効率化できるようになるためのChatGPTの研修を行なっております。

興味のある方はこちらからご確認ください。

ChatGPTの基礎知識とバージョンアップ

ChatGPTの技術がどのように進化しているかを理解するために、以下の重要な側面を解説します。

- GPT-3.5とGPT-4の比較

- ChatGPTのバージョンアップの影響

- ChatGPTとGoogle Bardの違い

ChatGPTの最新の進歩と、これらがユーザーの体験やセキュリティにどのように影響を与えるかを詳しく見ていきます。

GPT-3.5とGPT-4の比較

両者ともに強力な言語モデルですが、いくつかの重要な違いがあります。

GPT-3.5は高速で回答を生成する一方、GPT-4はより複雑な文脈を理解し、細やかなニュアンスを捉える能力が向上しています。

例えば、GPT-4は文学的な分析や技術的な説明をより詳細に行えるように設計されています。

ChatGPTのバージョンアップの影響

ChatGPTがバージョンアップしたことで、ユーザー体験が向上しました。

新しいバージョンでは、より自然で人間らしい対話が可能になりました。

ユーザーからの質問に対しても適切なコンテキストで応答できるようになります。

これにより、企業が顧客サービスを自動化する際の効率が大幅に向上します。

ChatGPTとGoogle Bardの違い

ChatGPTとGoogle Bardは、それぞれ異なるアプローチで開発されています。

ChatGPTは広範なデータに基づく学習を行っています。

一方でGoogle Bardは特定の情報源からの情報を取り込みつつ、ユーザーの質問に対して直感的な回答を生成することを目指しています。

例えば、Google Bardは最新のニュースイベントに基づいた情報を提供することができますが、ChatGPTは広い範囲の情報を総合的に理解し、回答します。

このように、ChatGPTの基礎知識を理解することは、AIをより効果的に活用するための第一歩です。

それぞれのバージョンの特性を把握し、適切なシナリオで利用することが重要です。

ChatGPTとセキュリティリスク

ChatGPTが普及する中で、以下のセキュリティリスクに注意が必要です。

- 機密情報の漏洩リスク

- 著作権違反のリスク

- 誤情報とフェイクニュースの拡散

これらのリスクはChatGPTの運用において重大な影響を及ぼす可能性があり、それぞれの対策と理解を深めることが不可欠です。

次に、これらのリスクの詳細とそれに対する対策について掘り下げていきます。

機密情報の漏洩リスク

ChatGPTがアクセスできるデータの中には、個人情報や企業秘密が含まれる場合があります。

これらの情報が偶発的に漏れ出すことで、個人のプライバシー侵害や企業の競争力低下につながる可能性があります。

例えば、誤って機密情報がチャットボットに入力された場合、その情報が外に漏れてしまう危険性があります。

著作権違反のリスク

ChatGPTは大量のテキストデータを学習に使用しており、ユーザーからの質問に対して知識を再構成して回答します。

この過程で、著作権で保護されたコンテンツを無意識に利用し、著作権違反が起こるおそれがあります。

これは、特にクリエイティブなコンテンツを生成する際に注意が必要です。

誤情報とフェイクニュースの拡散

ChatGPTは提供された情報を基に回答を生成しますが、その情報源が正確でない場合、偽情報が広がる危険性が存在します。

特に、ニュースや社会的に敏感な話題に関する質問に対しては、誤った情報によって大きな悪影響が生じる可能性があります。

例えば、健康に関する間違った情報や、政治的なフェイクニュースが社会に混乱をもたらすことが考えられます。

これらのセキュリティリスクに対応するためには、使用する前にしっかりとリスク評価を行い、適切なガイドラインとプロトコルを設定することが不可欠です。

さらに、ChatGPTの応答を観察し、不適切な内容が含まれていないか定期的にチェックすることも重要です。

このようにして、ChatGPTを安全に利用するための基盤を整えることができます。

ChatGPTの悪用例と対処法

ChatGPTの技術がもたらす便利さの裏で、以下の悪用のリスクも存在します。

- フィッシング詐欺とマルウェアの作成

- 悪用されるサイバー攻撃の事例

- 悪意あるコンテンツの作成防止策

これらのリスクへの対処法を詳しく解説することで、ChatGPTを安全に使うことを促進し、リスクを軽減する方法を提供します。

フィッシング詐欺とマルウェアの作成

ChatGPTが生成するテキストのリアルさは、フィッシング詐欺に利用されることがあります。

詐欺師は、人間らしい対話を模倣して信頼を得ることで、個人情報を盗み出す試みを行うことがあります。

例えば、偽の銀行員を装い、ユーザーにログイン情報を尋ねるメッセージが該当します。

このリスクに対処するためには、ChatGPTを使った対話システムでの認証プロセスを強化し、ユーザー教育を徹底することが必要です。

悪用されるサイバー攻撃の事例

サイバー攻撃者は、ChatGPTを利用して技術的な知識がないユーザーをだましてマルウェアをダウンロードさせることがあります。

これは、AIが作成した説得力のある偽のソフトウェアアップデート通知を通じて行われることが多いです。

これに対抗するには、企業や個人が正式なソフトウェア配布チャネルのみを利用するよう徹底し、AI生成コンテンツに対する警戒心を持たせることが有効です。

悪意あるコンテンツの作成防止策

ChatGPTを使って意図的に誤情報や偏見のある内容を拡散する事例も報告されています。

こうした内容が広まるのを避けるためには、生成されたコンテンツを事前にレビューするプロセスを設けることが効果的です。

また、ユーザーがコンテンツの出所を確認できるように透明性を高めることも重要です。

これらの対策を講じることで、ChatGPTの不正使用のリスクを最低限にするため、その長所を充分に使うことができます。

安全な使用環境の確保は、技術の進歩と共に常に更新されるべきです。

ChatGPTの利用ポリシーとガイドライン

ChatGPTの導入と運用におけるガイドラインとポリシーを整備することは、安全かつ効率的な使用を保証します。

本セクションでは、次の重要なポイントに焦点を当てて解説します。

- 企業における利用ガイドラインの策定

- 従業員教育とセキュリティ意識の向上

- APIと企業向けプランの利用メリット

これらのガイドラインと教育プログラムがどのようにして企業のセキュリティ対策を強化し、ChatGPTの潜在的なリスクを管理するのかを具体的に説明します。

企業における利用ガイドラインの策定

企業がChatGPTを導入する際には、その利用目的と方法を明確に定義する必要があります。

利用ガイドラインは、どのような情報がAIによって扱われるのか、どのようにして個人のプライバシーや企業の機密情報が保護されるのかを規定します。

例えば、顧客サービスでChatGPTを使用する場合、顧客からの問い合わせにどう応じるか、どのような回答が許可されているかを明確にします。

従業員教育とセキュリティ意識の向上

ChatGPTの導入に当たっては、従業員への教育が不可欠です。

これには、AIの能力と制約を把握し、セキュリティプロトコルを遵守するためのトレーニングが含まれます。

従業員がセキュリティ意識を持って行動することで、悪意のある利用や情報漏洩のリスクを減らすことができます。

APIと企業向けプランの利用メリット

企業向けにカスタマイズされたChatGPTのAPIやプランを利用することには多くのメリットがあります。

例えば、企業は特定のニーズに応じてChatGPTの機能を調整でき、より高度なセキュリティ管理が可能になります。

APIを利用することで、システムのセキュリティを強化し、データの流れを適切に管理することができます。

これらのポリシーとガイドラインを設けることで、ChatGPTの利用が企業の運営において正の効果をもたらし、セキュリティのリスクを上手に管理できるようになります。

それぞれの企業が独自の環境に合わせたポリシーを策定し、AI技術を安全に、かつ効果的に利用することが求められます。

ChatGPT利用時のデータ保護とプライバシー

ChatGPTの利用が広がる中で、データ保護とプライバシーの確保は極めて重要です。

このセクションでは、次のトピックに焦点を当てて解説します。

- チャット履歴の管理とプライバシー設定

- 機密情報を扱う際の注意点

- 企業データの安全な管理方法

これらの要素について深く掘り下げることで、ChatGPTを利用する際のリスクを軽減し、ユーザーと企業の両方に安全な環境を提供する方法を提案します。

チャット履歴の管理とプライバシー設定

ChatGPTの利用においては、チャット履歴の適切な管理が必要です。

個人情報が含まれる場合、その情報が第三者に漏れることのないよう厳重に保護する必要があります。

例えば、医療相談や法律相談など、個人情報を扱う場面では、特にプライバシー設定を厳格にすることが推奨されます。

機密情報を扱う際の注意点

ChatGPTを通じて機密情報が扱われる場合、その取り扱いには最大限の注意が必要です。

特に、企業が内部情報や顧客情報をChatGPTを使って処理する場合、情報漏洩を防ぐためのセキュリティ対策を行うことが必要不可欠です。

これには、暗号化技術の利用やアクセス権限の厳格な管理が含まれます。

企業データの安全な管理方法

企業がChatGPTを利用する際には、企業データの安全な管理が求められます。

これには、データのバックアップの定期的な実施、アクセスログの管理、セキュリティの継続的な監視と評価が必要です。

たとえば、顧客データベースを扱う際には、そのデータがどのように使用され、誰がアクセス可能かを明確に規定し、遵守することが重要です。

これらの対策を講じることで、ChatGPTを使用する際のデータ保護及びプライバシーを確保し、ユーザーからの信頼を得ることができます。

また、これにより法的責任からも保護されることになります。データ保護とプライバシーの管理は、技術の進歩に伴い常に更新されるべきです。

ChatGPTのセキュリティ設定方法

ChatGPTの活用が広がる中で、サイバーセキュリティ対策の重要性が高まっています。

このセクションでは、ChatGPTの利用における重要な設定について説明します。

- オプトインとオプトアウト

- ChatGPTにおけるオプトアウト

- ChatGPTのオプトアウトの設定方法

オプトインとオプトアウト

オプトインとは、ユーザーが情報提供を許可する意思表明をすることで、個人情報の取得やサービスの提供が開始される形態です。

この方式では、ユーザーが明示的に同意を示すことによって初めて企業側が情報を取得・使用することが可能になります。

オプトアウトとは、ユーザーが情報提供を禁止する意思表明をすることで、個人情報の取得やサービスの提供を停止する形態です。

この方式では、情報がデフォルトで収集されることが前提となっており、ユーザーが活動的に情報提供を拒否しなければならない状況です。

ChatGPTにおけるオプトアウト

ChatGPTを利用する際、2023年4月以降、ユーザーが入力したデータをChatGPTの学習に使用しない設定(オプトアウト)を行うことが可能になりました。

これにより、ユーザーは自らの情報をChatGPTの学習から守ることができ、プライバシーの保護が図られます。

オプトアウトの設定を行わない場合、入力した情報がChatGPTの学習に使用される可能性があります。

ChatGPTのオプトアウトの設定方法

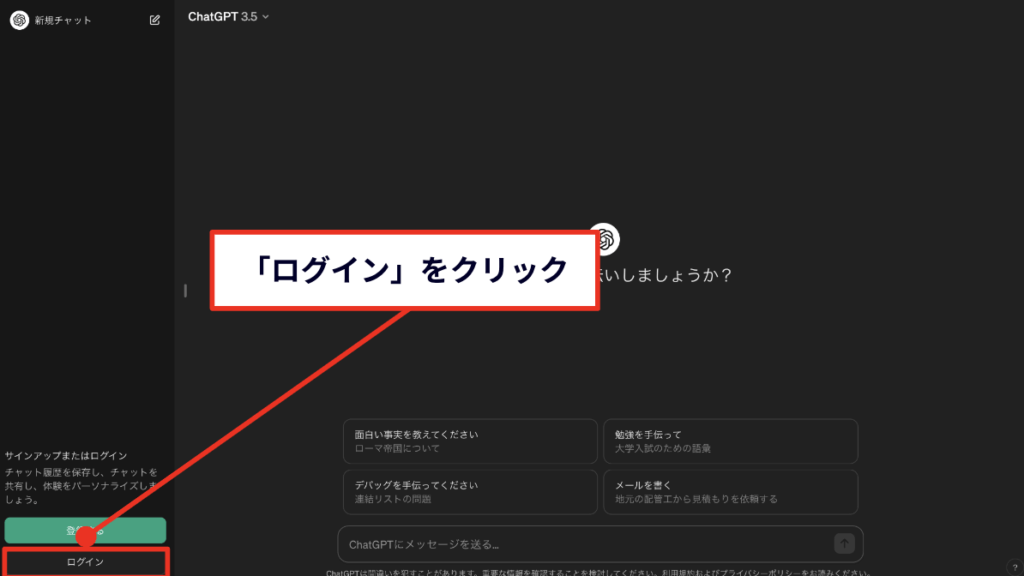

まずは、ChatGPTの公式ウェブサイトにアクセスし、「ログイン」します。

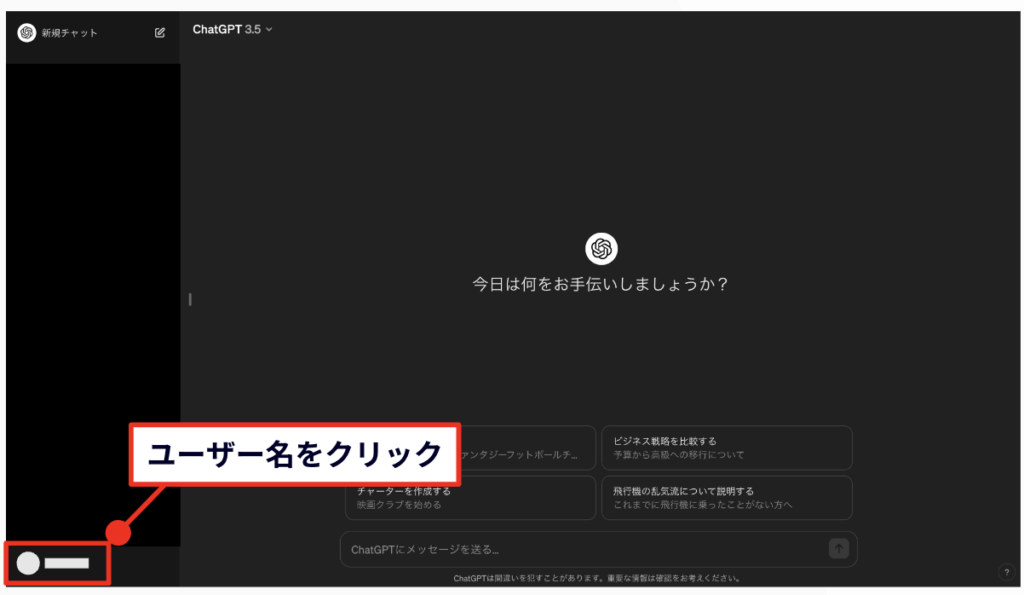

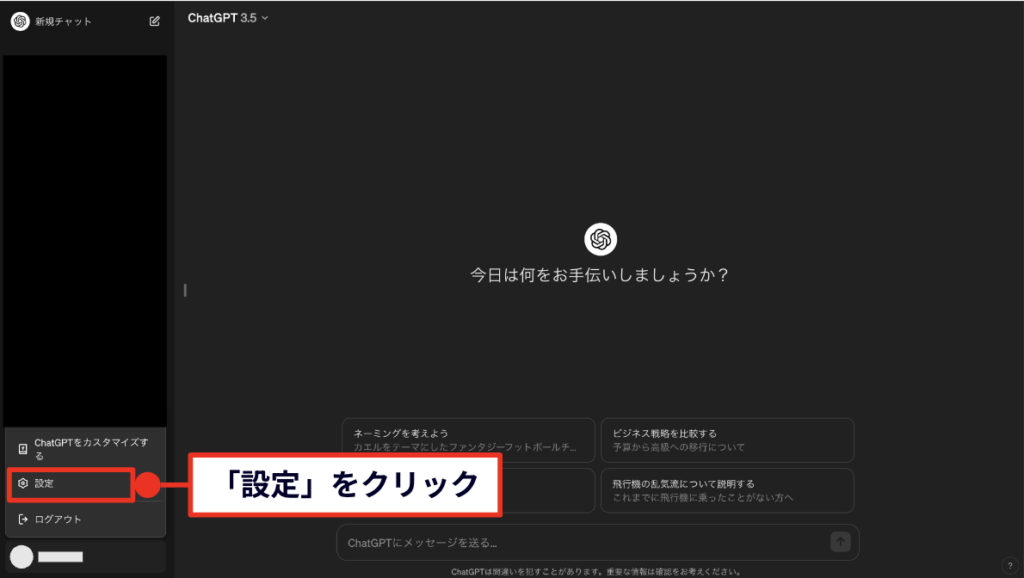

その後、ユーザー名をクリックして「設定」に進みます。

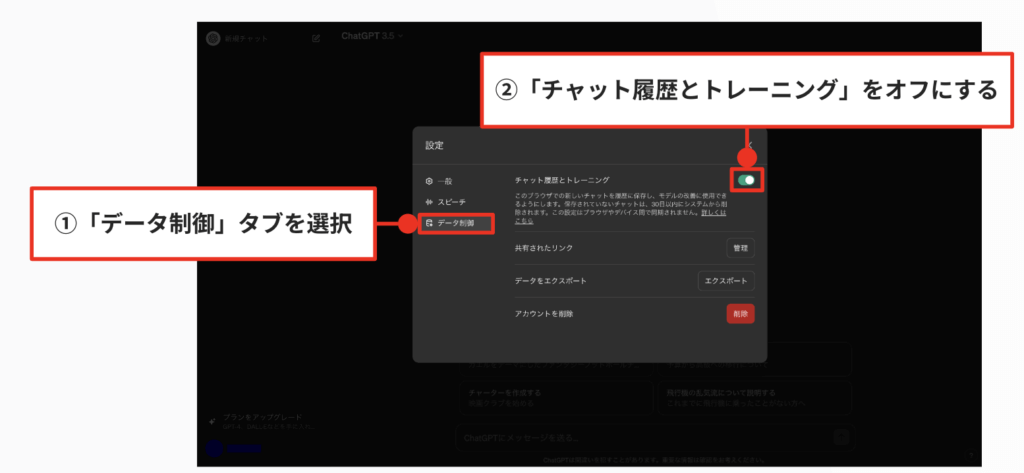

そこで「データ制御」タブを選択して、「チャット履歴とトレーニング」をオフにすることで、オプトアウト設定を完了できます。

これにより、ユーザーがChatGPTに提供したデータは、学習やサービスの改善のために使用されないようになります。

ChatGPTの安全な使用方法

ChatGPTの効果的かつ安全な使用には、具体的な対策が必要です。

このセクションでは、次の主要な側面を詳しく解説します。

- チャット履歴と学習データの管理

- 信頼できるソースからの情報利用

- 不正アプリとフィッシング詐欺からの保護

これらのポイントに焦点を当てることで、ChatGPTの利用者が直面する可能性のあるリスクを軽減し、全体的なセキュリティを向上させる方法を提供します。

チャット履歴と学習データの管理

ChatGPTの使用においては、チャット履歴と学習データの管理が極めて重要です。

これには、個人情報が含まれないように注意を払い、必要がなくなったデータは適切に削除することが含まれます。

たとえば、ユーザーが終了したセッションのデータは、プライバシー保護の観点から定期的にクリアすることが望ましいです。

信頼できるソースからの情報利用

ChatGPTを使用する際には、信頼できるソースからの情報に基づいて操作することが重要です。

これには、誤情報やフェイクニュースをフィルタリングし、確実なデータに基づいてChatGPTが回答することが含まれます。

信頼できる情報源の選定は、ユーザーに対して正確で価値のある応答を提供するために不可欠です。

不正アプリとフィッシング詐欺からの保護

ChatGPTを安全に使用するためには、不正アプリやフィッシング詐欺から身を守ることも重要です。

ユーザーは、ChatGPTを組み込んだアプリケーションが正式なものであることを確認し、不審なリンクや要求には応じないよう注意を払う必要があります。

また、セキュリティソフトウェアを最新の状態に保ち、不審な活動があった場合には速やかに対処することが推奨されます。

これらの対策を適切に実施することで、ChatGPTを使用する際のセキュリティリスクを大幅に軽減し、安心して利用することが可能になります。

常にセキュリティ対策を最新の状態に保つことが、効果的かつ安全な使用には不可欠です。

ChatGPTの法的・倫理的問題

ChatGPTの使用が広がる中で、法的および倫理的な問題が重要な議論の対象となっています。

このセクションでは、以下の重要な側面に焦点を当てて解説します。

- 著作権と知的財産権の問題

- 倫理的な利用基準と問題点

- AIの利用における法的規制の動向

これらの問題に対する理解を深めることで、ChatGPTの適切な使用を促し、将来的なリスクを避けるための方策を提供します。

著作権と知的財産権の問題

ChatGPTは多数のテキストデータから学習を行いますが、その過程で著作権で保護されている作品を扱うことがあります。

これにより、無意識のうちに著作権を侵害するリスクが生じる場合があります。

例えば、ChatGPTがユーザーの問いに応じて、著作権で保護された文学作品の一部を引用して応答することがそれにあたります。

企業や開発者は、これらの法的リスクを適切に管理するために、利用規約の策定や著作権者との調整が必要です。

倫理的な利用基準と問題点

ChatGPTを倫理的に使用するための基準を設けることも重要です。

AIが生成する内容が社会的に不適切なものでないよう、人種、性別、宗教に関する偏見を持たないよう配慮する必要があります。

また、ユーザーに提供する情報が誤解を招く内容でないよう、精度の高い情報提供が求められます。

例えば、健康に関する誤った情報を提供することなく、正確な知識と情報が伝えられるようにすることが挙げられます。

AIの利用における法的規制の動向

AI技術、特にChatGPTのような高度な自然言語処理ツールの普及に伴い、多くの国で新たな法規制が検討されています。

これには、データ保護法、プライバシー法、AIの倫理的使用に関する規制が盛り込まれています。

これらの法的枠組みは、AIが個人の権利を侵害することなく、社会にとって有益な方法で利用されることを保証するために重要です。

これらの法的および倫理的問題に適切に対処することで、ChatGPTを含むAI技術の健全な発展と社会への貢献が期待できます。

それには、技術開発者、ユーザー、法制度の三者が協力し、連携して取り組む必要があります。

ChatGPTのセキュリティ強化策

ChatGPTのセキュリティをさらに強化するためには、効果的な措置が必要です。

この節では、特に以下の点に焦点を当てて説明します。

- エンドポイントセキュリティの利用

- ネットワークセキュリティの強化

- セキュリティ意識向上トレーニング

これらを通じて、ChatGPTのセキュリティを強化し、将来的なセキュリティ脅威に効果的に対応する方法を探ります。

エンドポイントセキュリティの利用

ChatGPTを組み込んだシステムにおいて、エンドポイントセキュリティの強化は極めて重要です。

これには、個々のデバイスのセキュリティを強化することが含まれます。

例えば、マルウェア防御、侵入防止システム、およびデータ暗号化を用いることで、外部の攻撃に抵抗する力を向上させます。

これにより、不正アクセスやデータ漏洩のリスクを軽減することができます。

ネットワークセキュリティの強化

ChatGPTを活用する際には、ネットワークセキュリティも同様に重要です。

効果的なネットワーク監視と脆弱性管理を行うことで、不正な通信や攻撃を早期に検出し、対処することが可能です。

また、ファイアウォールや仮想プライベートネットワーク(VPN)の適切な使用が、内部ネットワークの保護に役立ちます。

セキュリティ意識向上トレーニング

技術的な対策と並行して、ユーザーや従業員のセキュリティ意識を高めることが重要です。

定期的なセキュリティトレーニングと教育プログラムを通じて知識を提供することで、組織全体のセキュリティを高めることができます。

これにより、個々のユーザーがセキュリティの第一線として機能し、リスクを低減します。

これらのセキュリティ強化策を適切に実施することで、ChatGPTを安全に使用できるよう保障し、セキュリティリスクに効果的に対処することができます。

これにより、ChatGPTの潜在的な利点を最大限に活用しつつ、ユーザーや企業のデータを保護することが可能になります。

ChatGPTの今後とセキュリティの課題

ChatGPTの将来的な展望と共に、対処すべきセキュリティの課題も増加しています。

このセクションでは、次の重要なポイントに焦点を当てて解説します。

- 技術の進化とセキュリティ対策の変化

- AIの利用拡大に伴うセキュリティの新たな課題

- 国際的なセキュリティ基準と規制の必要性

これらの要素について詳しく掘り下げることで、未来のセキュリティ環境への適応とそれに対応する戦略を検討します。

技術の進化とセキュリティ対策の変化

ChatGPTの技術は日々進化しており、それに合わせてセキュリティ対策も進化し続ける必要があります。

例えば、新しいバージョンのChatGPTでは、より精緻な自然言語理解が可能になる一方で、これを悪用した新たな攻撃手法も考えられます。

そのため、進化する技術に即したセキュリティ対策を定期的に更新し続けることが必要です。

AIの利用拡大に伴うセキュリティの新たな課題

ChatGPTのようなAIの利用が拡大するにつれ、セキュリティの問題も多様化します。

AIを利用したフィッシング攻撃や、ディープフェイクなど、新しい形式のセキュリティリスクが出現しています。

これらに対抗するためには、AI特有のリスクを理解し、それに対応するための技術と知識が求められます。

国際的なセキュリティ基準と規制の必要性

ChatGPTを含むAI技術の国際的な利用を考慮したとき、各国の法規制やセキュリティ基準の違いが顕著になります。

国際的なセキュリティ基準や法的枠組みを設けることが、グローバルな規模での安全なAI利用を保障する上で重要です。

これにより、国境を超えたデータの流れとAIの活用が安全に行えるようになります。

このように、ChatGPTの今後の発展とセキュリティの課題には、技術的なアップデートだけでなく、法的、倫理的な取り組みも含めた幅広い対策が求められます。

これらを適切に管理することで、ChatGPTの可能性を存分に引き出して、同時にリスクを最低限に抑えることが可能です。

ChatGPTの教育と研修でのセキュリティ意識の向上

このセクションでは、セキュリティ教育と継続的な研修がどのようにして組織全体のセキュリティ意識を向上させるかについて詳しく解説します。

具体的には、以下のトピックに焦点を当てます。

- AIとセキュリティに関する基礎教育

- セキュリティインシデント対応研修

- 従業員向けの定期的なセキュリティ更新と情報共有

これらの教育プログラムが組織にどのような利益をもたらし、セキュリティリスクに効果的に対応するためのスキルを従業員にどのように教えるかについて掘り下げます。

AIとセキュリティに関する基礎教育

AI技術の基本的な理解を深めることは、その安全な利用のための第一歩です。

従業員に対して、ChatGPTの動作原理や、それが生成する情報の利用方法を教えることで、潜在的なリスクを理解させることが重要です。

たとえば、AIがどのように情報を処理し、応答を生成するかの基礎知識を提供することで、ユーザーがこれらの技術をより効果的かつ安全に活用できるようになります。

セキュリティインシデント対応研修

セキュリティインシデントが発生した場合の適切な対応方法を従業員に教育することは、リスク管理の中核をなす要素です。

緊急時にどのように行動するか、誰に報告するか、どのように問題を解決するかの手順を習得させることが、組織全体のセキュリティを向上させます。

これにより、インシデント発生時に迅速かつ効果的に対応できるようになります。

従業員向けの定期的なセキュリティ更新と情報共有

技術の進化に伴い、セキュリティ脅威も常に変化しています。

そのため、従業員に対するセキュリティ教育は一度きりではなく、継続的なプロセスであるべきです。

最新のセキュリティのリスクと対策、ポリシーの変更について定期的に情報を更新し、共有することが求められます。

これにより、従業員が常に最新の知識を持って対応できるようになります。

これらの教育と研修プログラムを通じて、ChatGPTをはじめとするAI技術の安全な使用を推進し、セキュリティ意識を組織全体で高めることができます。

結果として、技術の効果を最大限に活用しつつ、リスクを最小化することが可能になります。

ChatGPTの将来性とセキュリティの展望

ここでは、ChatGPTの技術進化とそれに伴うセキュリティ対策の重要性について掘り下げていきます。

具体的に取り上げる内容は以下の通りです。

- AI技術の発展とセキュリティ対策の進化

- 次世代セキュリティ技術とChatGPTの統合

- 社会的、倫理的責任とAIの未来

これらのポイントを通じて、AIとセキュリティの未来に対する理解を深め、対応策と責任の重要性を説明します。

AI技術の発展とセキュリティ対策の進化

ChatGPTの技術は急速に進化しており、その進化にはセキュリティ対策も同様に進化する必要があります。

AIがより複雑なタスクをこなすようになるにつれて、その操作やデータ処理に関するセキュリティリスクも増加します。

例えば、より精緻なデータ分析能力は、個人情報の取り扱いにおけるセキュリティ対策を強化する必要があることを意味します。

これには、データの暗号化、アクセス制御の強化などが含まれます。

次世代セキュリティ技術とChatGPTの統合

ChatGPTの発展は、次世代のセキュリティ技術との統合を必要とします。

これには、機械学習モデル自体のセキュリティを強化する新しい手法の開発が含まれます。

AIが自身のセキュリティを自律的に管理し、脅威をリアルタイムで検出し対処できるようになることが理想的です。

たとえば、異常検知システムがAIに組み込まれ、内部からの脅威や外部からの攻撃を即座に識別できるようになることが考えられます。

社会的、倫理的責任とAIの未来

ChatGPTを含むAI技術の未来は、その社会的および倫理的な責任を如何にして果たすかにも依存します。

AI技術が社会に与える影響は計り知れず、その利用が倫理的な基準に沿って行われることが求められます。

また、国際的なセキュリティ基準や規制の策定が、技術の安全な利用を保証するために重要です。

これには、技術の利用者だけでなく、開発者、政策立案者が連携して取り組む必要があります。

これらの展望を踏まえると、ChatGPTの未来は明るいものでありながら、多くの課題に対処する必要があることがわかります。

セキュリティ対策の進化とともに、社会的、倫理的責任を適切に管理することが、この技術の健全な発展を支える鍵となるでしょう。

まとめ

ChatGPTの活用は多くの可能性を秘めていますが、それには適切なセキュリティ対策が不可欠です。

この記事では、ChatGPTを安全に利用する手段、セキュリティリスク、法的・倫理的問題、および今後の展望について詳しく解説しました。

ChatGPTの将来には期待が持てるものですが、そのセキュリティ面での課題には継続的に注目し、対策を講じることが必要です。

この方法によって、ChatGPTを安全に、かつ効果的に活用することができるでしょう。

今後もAI技術の進化とそれに伴うセキュリティ対策の進展には注目が集まることになります。